Dispositivi di elaborazione dell'evoluzione, tipi, esempi

Il dispositivi di elaborazione computer sono unità che svolgono un ruolo importante nelle operazioni di processo di un computer. Sono utilizzati per elaborare i dati, seguendo le istruzioni di un programma.

L'elaborazione è la funzione più importante del computer, perché in questa fase viene effettuata la trasformazione dei dati in informazioni utili, utilizzando molti dispositivi di elaborazione del computer..

La funzione principale dei dispositivi di elaborazione è quella di avere la responsabilità di ottenere informazioni eloquenti dai dati che vengono trasformati con l'aiuto di molti di questi dispositivi..

L'elaborazione audio e video consiste nel ripulire i dati in modo tale che siano più piacevoli per l'orecchio e per gli occhi, facendoli apparire più realistici.

Questo è il motivo per cui può essere visto meglio con alcune schede video rispetto ad altre, perché la scheda video elabora i dati per migliorare il realismo. Lo stesso accade con le schede audio e la qualità audio.

Indice articolo

- 1 processore

- 2 Evoluzione dal primo al presente

- 2.1 Fase iniziale

- 2.2 Relè e tubi a vuoto

- 2.3 Transistor

- 2.4 Circuiti integrati

- 2.5 Microprocessore

- 3 tipi

- 3.1 Dispositivi di elaborazione multi-core

- 3.2 Dispositivi mobili di elaborazione

- 3.3 Unità di elaborazione grafica (GPU)

- 4 esempi

- 4.1 - Unità centrale di elaborazione (CPU)

- 4.2 - Scheda madre

- 4.3 - Chip

- 4.4 - Orologio

- 4.5 - Slot di espansione

- 4.6 - Bus dati

- 4.7 - Bus di controllo

- 4.8 - Scheda video

- 4.9 - Unità di elaborazione grafica (GPU)

- 4.10 - Scheda di interfaccia di rete (NIC)

- 4.11 - Scheda di rete wireless

- 4.12 - Scheda audio

- 4.13 - Controller di archiviazione di massa

- 5 Riferimenti

Processore

Ogni volta che le informazioni raggiungono un computer da un dispositivo di input, come la tastiera, queste informazioni devono percorrere un percorso intermedio prima di poter essere assegnate a un dispositivo di output, come il monitor..

Un dispositivo di elaborazione è qualsiasi dispositivo o strumento nel computer responsabile della gestione di questo percorso intermedio. Gestiscono funzioni, eseguono calcoli diversi e controllano anche altri dispositivi hardware.

I dispositivi di elaborazione convertono tra diversi tipi di dati, nonché manipolano ed eseguono attività con i dati.

Solitamente, il termine CPU corrisponde a un processore, e più precisamente alla sua unità di calcolo e unità di controllo, distinguendo così questi elementi dai componenti esterni del computer, come la memoria principale e i circuiti di input / output..

Il processore lavora in stretto coordinamento con la memoria principale e le periferiche di archiviazione.

Potrebbero esserci altri sistemi e periferiche che funzionano per aiutare a raccogliere, archiviare e diffondere i dati, ma le attività di elaborazione sono uniche per il processore..

Evoluzione dal primo al presente

Stato iniziale

I primi computer, come l'ENIAC, dovevano essere cablati fisicamente ogni volta che veniva eseguita un'attività diversa.

Nel 1945, il matematico von Neumann distribuì uno schizzo per un computer a programma memorizzato, chiamato EDVAC, che sarebbe stato finalmente completato nel 1949..

I primi dispositivi che potrebbero essere propriamente chiamati CPU arrivarono con l'arrivo di questo computer con un programma memorizzato.

I programmi creati per EDVAC sono stati archiviati nella memoria principale del computer, invece di dover essere stabiliti tramite il cablaggio del computer.

Pertanto, il programma eseguito da EDVAC poteva essere sostituito con una semplice modifica del contenuto della memoria.

Le prime CPU erano design unici che venivano utilizzati all'interno di un computer specifico. Successivamente, questo metodo di progettazione individuale delle CPU per una particolare applicazione ha consentito lo sviluppo di processori multitasking in gran numero..

Relè e tubi a vuoto

Erano comunemente usati come dispositivi di commutazione. Un computer necessitava di migliaia di questi dispositivi. I computer a tubo come EDVAC si bloccavano in media ogni otto ore.

Alla fine, le CPU basate su valvole divennero indispensabili perché i vantaggi di avere una velocità apprezzabile superavano il loro problema di affidabilità..

Queste prime CPU sincrone funzionavano a una bassa velocità di clock rispetto agli attuali progetti microelettronici, in gran parte a causa della bassa velocità degli elementi di commutazione utilizzati nella loro fabbricazione..

Transistor

Durante gli anni '50 e '60, le CPU non dovevano più essere costruite sulla base di dispositivi di commutazione grandi, guasti e fragili, come relè e valvole a vuoto..

Poiché le diverse tecnologie hanno reso possibile la produzione di dispositivi elettronici più piccoli e più affidabili, è aumentata anche la complessità nella progettazione della CPU. Il primo miglioramento di questo tipo è stato ottenuto con l'avvento del transistor.

Con questo progresso, è stato possibile realizzare CPU di maggiore complessità e che fallivano molto meno in uno o più circuiti stampati. I computer basati su transistor offrivano una serie di miglioramenti rispetto ai precedenti.

Oltre a offrire un consumo energetico inferiore ed essere molto più affidabili, i transistor hanno permesso ai processori di lavorare più velocemente, grazie al basso tempo di commutazione che un transistor aveva rispetto a una valvola a vuoto.

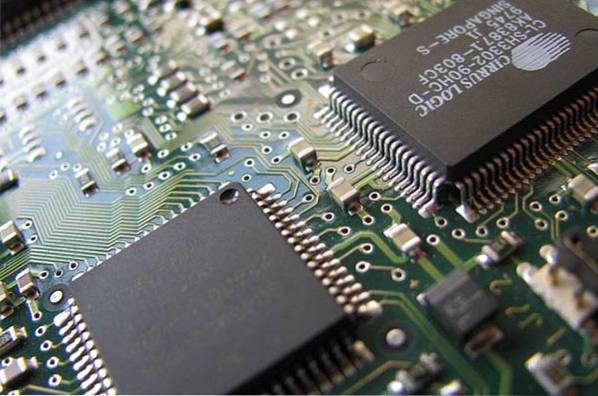

Circuiti integrati

Il transistor MOS è stato inventato dai Bell Labs nel 1959. Ha un'elevata scalabilità, oltre a utilizzare molta meno elettricità ed essere molto più condensato dei transistor a giunzione bipolare. Ciò ha permesso di costruire circuiti integrati ad alta densità.

Così è stato sviluppato un metodo per produrre molti transistor interconnessi in un'area compatta. Il circuito integrato ha permesso di fabbricare un gran numero di transistor in un unico stampo o "chip" basato su semiconduttori..

La standardizzazione è iniziata nella fase dei macrocomputer e dei minicomputer a transistor e ha accelerato notevolmente con la diffusione capillare del circuito integrato, consentendo la progettazione e la produzione di CPU sempre più complesse..

Con il progredire della tecnologia microelettronica, è stato possibile inserire più transistor nei circuiti integrati, riducendo così il numero di circuiti integrati necessari per completare una CPU..

I circuiti integrati hanno aumentato il numero di transistor a centinaia e successivamente a migliaia. Nel 1968, il numero di circuiti integrati necessari per costruire una CPU completa era stato ridotto a 24, ciascuno contenente circa 1.000 transistor MOS..

Microprocessore

Prima dell'avvento dei microprocessori odierni, i computer utilizzavano più circuiti integrati sempre più piccoli che erano sparsi in tutto il circuito stampato..

La CPU come è conosciuta oggi è stata sviluppata per la prima volta nel 1971 da Intel, per funzionare nell'ambito dei personal computer..

Questo primo microprocessore era il processore a 4 bit denominato Intel 4004. Successivamente è stato sostituito da progetti più recenti con architetture a 8 bit, 16 bit, 32 bit e 64 bit..

Il microprocessore è un chip di circuito integrato fatto di materiale semiconduttore di silicio, con milioni di componenti elettrici nel suo spazio..

Alla fine è diventato il processore centrale per i computer di quarta generazione degli anni '80 e dei decenni successivi..

I microprocessori moderni compaiono nei dispositivi elettronici che vanno dalle automobili ai telefoni cellulari e persino nei giocattoli.

Tipi

In precedenza, i processori dei computer utilizzavano i numeri come identificazione, aiutando così a identificare i processori più veloci. Ad esempio, il processore Intel 80386 (386) era più veloce del processore 80286 (286).

Dopo che il processore Intel Pentium è entrato nel mercato, che logicamente avrebbe dovuto chiamarsi 80586, gli altri processori hanno iniziato a portare nomi come Celeron e Athlon.

Attualmente, a parte i vari nomi di processori, ci sono diverse capacità, velocità e architetture (32 bit e 64 bit).

Dispositivi di elaborazione multi-core

Nonostante le crescenti limitazioni nelle dimensioni del chip, il desiderio di produrre più potenza dai nuovi processori continua a motivare i produttori..

Una di queste innovazioni è stata l'introduzione del processore multi-core, un singolo chip a microprocessore in grado di avere un processore multi-core. Nel 2005, Intel e AMD hanno rilasciato prototipi di chip con design multi-core.

Il Pentium D di Intel era un processore dual-core che è stato paragonato al processore dual-core Athlon X2 di AMD, un chip destinato ai server di fascia alta..

Tuttavia, questo fu solo l'inizio delle tendenze rivoluzionarie nei chip a microprocessore. Negli anni successivi, i processori multicore si sono evoluti da chip dual-core, come Intel Core 2 Duo, a chip a dieci core, come Intel Xion E7-2850..

In generale, i processori multicore offrono più delle basi di un processore single-core e sono in grado di eseguire il multitasking e il multiprocessing, anche all'interno delle singole applicazioni..

Dispositivi mobili di elaborazione

Mentre i tradizionali microprocessori sia nei personal computer che nei supercomputer hanno subito un'evoluzione monumentale, l'industria del mobile computing si sta espandendo rapidamente e deve affrontare le proprie sfide..

I produttori di microprocessori stanno integrando tutti i tipi di funzionalità per migliorare l'esperienza individuale.

L'equilibrio tra avere una maggiore velocità e controllare il calore rimane un mal di testa, per non parlare dell'impatto sulle batterie mobili di questi processori più veloci..

Unità di elaborazione grafica (GPU)

Il processore grafico produce anche calcoli matematici, solo questa volta, con una preferenza per immagini, video e altri tipi di grafica.

Queste attività erano precedentemente gestite dal microprocessore, ma quando le applicazioni CAD ad alta intensità grafica sono diventate comuni, è emersa la necessità di hardware di elaborazione dedicato, in grado di gestire tali attività senza influire sulle prestazioni complessive del computer..

La GPU tipica è disponibile in tre diverse forme. Di solito è collegato separatamente alla scheda madre. È integrato con la CPU o si presenta come un chip aggiuntivo separato sulla scheda madre. La GPU è disponibile per desktop, laptop e anche computer portatili.

Intel e Nvidia sono i principali chipset grafici sul mercato, con quest'ultimo che è la scelta preferita per l'elaborazione grafica principale..

Esempi

- Unità di elaborazione centrale (CPU)

Il più importante dispositivo di elaborazione nel sistema informatico. Chiamato anche microprocessore.

È un chip interno del computer che elabora tutte le operazioni che riceve dai dispositivi e dalle applicazioni in esecuzione sul computer..

Intel 8080

Introdotto nel 1974, aveva un'architettura a 8 bit, 6.000 transistor, velocità di 2 MHz, accesso a 64 KB di memoria e prestazioni 10 volte superiori rispetto all'8008..

Intel 8086

Introdotto nel 1978. Utilizzava un'architettura a 16 bit. Aveva 29.000 transistor, funzionanti a velocità comprese tra 5 MHz e 10 MHz. Potrebbe accedere a 1 megabyte di memoria.

Intel 80286

È stato lanciato nel 1982. Aveva 134.000 transistor, funzionanti a velocità di clock da 4 MHz a 12 MHz. Primo processore compatibile con i processori precedenti.

Pentium

Introdotti da Intel nel 1993. Possono essere utilizzati con velocità da 60 MHz a 300 MHz. Quando è stato rilasciato, aveva quasi due milioni di transistor in più rispetto al processore 80486DX, con un bus dati a 64 bit..

Core Duo

Il primo processore Intel dual-core sviluppato per computer portatili, introdotto nel 2006. È stato anche il primo processore Intel utilizzato nei computer Apple..

Intel core i7

È una serie di CPU che coprono 8 generazioni di chip Intel. Ha 4 o 6 core, con velocità comprese tra 2,6 e 3,7 GHz. È stato introdotto nel 2008.

- Scheda madre

Anche designato scheda madre. È la scheda più grande all'interno del computer. Ospita la CPU, la memoria, i bus e tutti gli altri elementi.

Assegna l'alimentazione e fornisce un modo di comunicazione per consentire a tutti gli elementi hardware di comunicare tra loro.

- Patata fritta

Gruppo di circuiti integrati che lavorano insieme, mantenendo e controllando l'intero sistema informatico. Gestisce così il flusso di dati in tutto il sistema.

- Orologio

Serve per tenere il passo con tutti i calcoli del computer. Rafforza il fatto che tutti i circuiti all'interno del computer possono lavorare insieme simultaneamente.

- Slot di espansione

Presa situata sulla scheda madre. Viene utilizzato per collegare una scheda di espansione, fornendo così funzioni complementari a un computer, come video, audio, archiviazione, ecc..

- Bus dati

Set di cavi che la CPU utilizza per trasmettere informazioni tra tutti gli elementi di un sistema informatico.

- Indirizzo bus

Set di cavi conduttivi che portano solo indirizzi. Le informazioni fluiscono dal microprocessore alla memoria o ai dispositivi di input / output.

- Bus di controllo

Trasporta i segnali che informano lo stato dei diversi dispositivi. Normalmente il bus di controllo ha un solo indirizzo.

- Scheda grafica

Scheda di espansione che va nella scheda madre di un computer. Si occupa di elaborazione di immagini e video. Utilizzato per creare un'immagine su uno schermo.

- Unità di elaborazione grafica (GPU)

Circuito elettronico dedicato alla gestione della memoria per velocizzare la creazione di immagini destinate ad essere trasmesse su un dispositivo di visualizzazione.

La differenza tra una GPU e una scheda grafica è simile alla differenza tra una CPU e una scheda madre.

- Scheda di interfaccia di rete (NIC)

Scheda di espansione utilizzata per connettersi a qualsiasi rete, o anche a Internet, utilizzando un cavo con un connettore RJ-45.

Queste schede possono comunicare tra loro tramite uno switch di rete o se sono collegate direttamente.

- Scheda wireless

Quasi tutti i computer moderni hanno un'interfaccia per la connessione a una rete wireless (Wi-Fi), che è integrata direttamente nella scheda madre..

- Scheda audio

Scheda di espansione utilizzata per riprodurre qualsiasi tipo di audio su un computer, che può essere ascoltato attraverso gli altoparlanti.

Incluso nel computer, in uno slot di espansione o integrato nella scheda madre.

- Controller di archiviazione di massa

Gestisce l'archiviazione e il recupero dei dati archiviati in modo permanente su un disco rigido o un dispositivo simile. Ha una propria CPU specializzata per eseguire queste operazioni.

Riferimenti

- Computer Hope (2018). Dispositivo di elaborazione. Tratto da: computerhope.com.

- Am7s (2019). Cosa sono i dispositivi di elaborazione del computer? Tratto da: am7s.com.

- Solomon (2018). Tipi di hardware per computer - Dispositivi di elaborazione. Zig Link IT. Tratto da: ziglinkit.com.

- Hub Pages (2019). Dispositivi per l'elaborazione dei dati. Tratto da: hubpages.com.

- Wikipedia, l'enciclopedia libera (2019). Unità centrale di elaborazione. Tratto da: en.wikipedia.org.

- Computer Hope (2019). PROCESSORE. Tratto da: computerhope.com.

- Margaret Rouse (2019). Processore (CPU). Techtarget. Tratto da: whatis.techtarget.com.

Nessun utente ha ancora commentato questo articolo.